微软BitNet b1.58 2B4T模型推出 20亿参数仅占0.4GB内存

【太平洋科技快讯】近日,微软研究院宣布推出一款大型语言模型(LLM)——BitNet b1.58 2B4T,这款模型采用1.58 位低精度架构,内存仅占0.4GB。

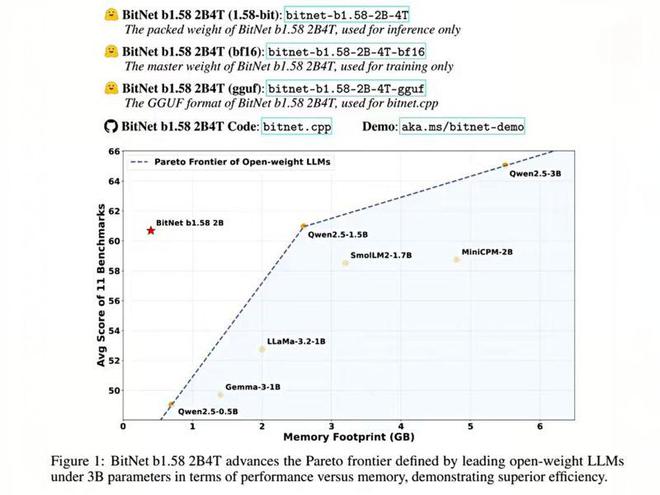

BitNet b1.58 2B4T 拥有 20 亿参数,其核心创新在于采用了原生 1-bit 训练方式,而非传统的训练后量化。这种创新架构使得模型在保持高性能的同时,大幅降低了计算资源的需求。在性能方面,BitNet b1.58 2B4T 直追同规模的全精度模型,而在内存占用上,其非嵌入内存占用仅为 0.4GB,远低于同类竞品 Gemma-3 1B 的 1.4GB 和 MiniCPM 2B 的 4.8GB。

据悉,BitNet b1.58 2B4T 模型摒弃了传统的 16 位数值,转而采用定制的 BitLinear 层,将权重限制为 -1、0 和 1 三种状态,形成三值系统。这种设计使得每个权重仅需约 1.58 位信息存储,极大地节省了内存空间。其次,层间激活值以 8 位整数量化,形成了独特的 W1.58A8 配置。此外,微软团队还调整了 Transformer 架构,引入了平方 ReLU 激活函数、标准旋转位置嵌入(RoPE)以及 subln 归一化等技术,确保了低位训练的稳定性。

微软团队的技术报告显示,BitNet b1.58 2B4T 在 GSM8K(数学)、PIQA(物理常识)等基准测试中表现优异,整体性能媲美主流的 1B-2B 参数全精度模型。该模型在能耗和 CPU 解码延迟上具有显著优势,每 token 能耗仅为 0.028 焦耳,解码延迟低至 29 毫秒。

尽管已取得显著成果,微软团队并未止步。他们计划进一步优化 BitNet b1.58 2B4T,包括增强对 GPU 和 NPU 的支持,将上下文窗口延长至 4096 token,探索多语言模型的开发,以及研究更大规模模型的硬件协同设计方案。

目前,BitNet b1.58 2B4T 已以 MIT 许可证在 Hugging Face 平台发布,供社区测试与应用。然而,需要注意的是,其高效性依赖于微软提供的专用 C 框架(bitnet.cpp),标准工具(如 Hugging Face transformers 库)无法完全展现其速度与能耗优势。